La pila

Nel 1799 Alessandro Volta riprese gli studi di Luigi Galvani sulla corrente elettrica, riuscendo a realizzare la prima pila (oggi detta voltaica), con i seguenti costituenti:

un supporto di legno posto verticalmente su una base circolare;

dischetti di rame e zinco

panno imbevuto di una soluzione acida formata da acqua e acido solforico

due fili di rame.

La pila di Volta consiste in dischetti di rame e zinco alternati, secondo lo schema rame-zinco-umido-rame-zinco, e così via, il tutto mantenuto verticalmente dalla struttura di legno esterna. Una volta disposti i dischetti e il panno sul supporto, collegando il primo e l'ultimo dischetto della colonna con due fili di rame, si viene a creare tra essi una differenza di potenziale in grado di produrre il passaggio di corrente. In realtà Volta credeva che il passaggio di corrente fosse dovuto alla differenza di potenziale originatasi in seguito al semplice contatto dei due metalli, mentre successivamente si capì che il passaggio di corrente è dovuto alla differenza di potenziale creata dai due metalli, provocata dalle reazioni chimiche alle quali concorre anche il mezzo umido.

Durante il funzionamento della pila, lo zinco si consuma mentre il rame rimane intatto o eventualmente si ossida. Questo perché lo zinco cede due elettroni e passa da Zn metallico a Zn2+, questi elettroni contrariamente a quanto si possa pensare non passano al rame, che serve solo per creare la differenza di potenziale, ma passano allo ione ossonio H3O+ formatosi dalla dissociazione ionica dell'acido solforico in acqua, che si trasforma in idrogeno molecolare gassoso H2. Infatti la differenza di potenziale che si può misurare ai capi di un solo di uno strato rame-umido-zinco con un voltmetro è di circa 0,7 V. Questa tensione equivale alla semicoppia Zn/Zn2+ utilizzando come altra semicoppia quella dell'idrogeno H2/H3O+.

Il dispositivo così costituito permise a Volta di produrre una corrente elettrica, di cui osservò il flusso riuscendo a indurre la contrazione dei muscoli di una rana morta.

Fino al 1869, anno dell'invenzione della dinamo, la pila fu l'unico mezzo di produzione della corrente elettrica il cui unico utilizzo commerciale era il telegrafo.

Pila Daniell

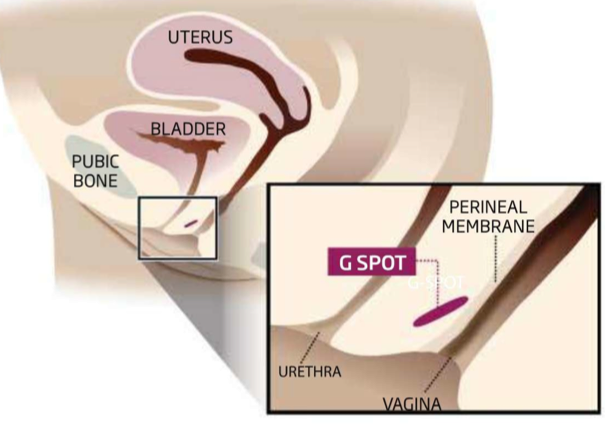

Schema di funzionamento di una pila Daniell

Nel 1836 John Frederic Daniell elaborò una pila, poi chiamata pila Daniell, sfruttando il prototipo inventato da Volta e apportando miglioramenti in termini di tensione e sicurezza d'uso. La cella è costituita da un compartimento anodico (semicella) formato da una barretta di zinco immersa in una soluzione di solfato di zinco (ZnSO4) 1 M e un compartimento catodico formato da una barretta di rame immersa in una soluzione di solfato di rame (CuSO4) 1 M.[3] Le due semicelle sono collegate da un ponte salino costituito da un tubo riempito da una soluzione satura di nitrato di potassio (KNO3) con dei tappi alle estremità permeabili a ioni e acqua.[3] Alla chiusura del circuito esterno con un conduttore, al catodo avviene la semireazione di riduzione:[4]

Cu2+(aq) + 2 e− → Cu(s)

(Eº = +0,34 V)

per cui ioni Cu2+ scompaiono dalla soluzione e si depositano come metallo sulla lamina. All'anodo avviene la semireazione di ossidazione:[4]

Zn(s) → Zn2+(aq) + 2 e−

(Eº = −0,76 V)

per cui dello zinco metallico si stacca dalla lamina raggiungendo la soluzione come ioni Zn2+. La reazione completa è:[4]

Zn(s) + Cu2+(aq) → Zn2+(aq) + Cu(s)

(∆Eº = 1,1 V)

Per effetto di questa reazione nel comparto catodico mancherebbero cariche positive, mentre nel comparto anodico si avrebbe un eccesso di cariche positive. Il tutto però viene compensato perché gli ioni potassio (K+) e nitrato (NO

−

3

) del ponte salino si spostano raggiungendo il compartimento catodico ed anodico, rispettivamente, ristabilendo l'elettroneutralità della soluzione, in accordo con la legge di Kirchhoff delle correnti. Gli elettroni nel circuito esterno girano dalla barretta di zinco a quella di rame e quindi la corrente convenzionale positiva I va dal rame allo zinco. Il potenziale teorico della pila Daniell è ∆Eº = Eº(Cu2+/Cu)−Eº(Zn2+/Zn)=1,10 V[5] ottenibile in condizioni quasi statiche reversibili, differenza tra il potenziale catodico (polo positivo) e quello anodico (polo negativo).

Cronologia

Nel 1801 Alessandro Volta illustra la sua invenzione a Napoleone Bonaparte.

1799: viene realizzata la pila di Volta.[6]

1801: la pila di Volta viene presentata all'Institut National des Sciences et Arts.[7]

1812: Giuseppe Zamboni realizza la prima pila a secco al biossido di manganese.[8][9]

1816: William Hyde Wollaston realizza la pila a tazze.[8]

1836: viene messa a punto la pila Daniell.[10]

1838: viene realizzata la pila di Grove.[10]

1841: viene realizzata la pila di Bunsen.[10]

1844: primo utilizzo commerciale dell'elettricità prodotta da batterie: il telegrafo.

1859: viene realizzato da Gaston Planté il primo accumulatore (Batteria piombo-acido).[11]

1866: Georges Leclanché inventa e brevetta il progenitore della pila a secco (soluzione elettrolita ancora acquosa).[11]

1869: viene inventata la dinamo, il primo metodo per la produzione non chimica di elettricità.

1886: Carl Gassner brevetta una pila a secco contenente pasta elettrolita e non più soluzione acquosa.

1893: viene inventata la pila Weston.[12]

1911: la pila Weston viene adottata come riferimento standard internazionale per la misura della forza elettromotrice.[12]

1914: la pila zinco-aria viene ideata da Charles Féry.[12]

1936: viene ideata una pila a combustibile a metano da Emil Baur e H. Preis.[12]

1942: viene ideata la batteria al mercurio da Samuel Ruben[12]

1947: viene ideata una pila a combustibile con elettrolita solido da O.K. Davtyan.[12]

1950: viene ideata una pila all'ossido di argento da Samuel Ruben.[12]

1950: nel corso degli anni '50 viene ideata da Lewis Urry la batteria alcalina.[12]

1954: viene realizzata da Francis Thomas Bacon una pila a combustibile a idrogeno e ossigeno, con elettrolita alcalino.[12]

1957: inizia la commercializzazione delle pile al mercurio (Ruben-Mallory).[12]

1963: le celle a combustibile vengono utilizzate per la prima volta su un veicolo spaziale.[12]

1970: vengono realizzate le prime batterie non ricaricabili al litio da compagnie americane e giapponesi.[12]

1987: viene realizzata la pila alluminio-aria.[12]

1990: iniziano i divieti di produzione delle batterie al mercurio (Ruben-Mallory).[12]

Pila di Zamboni

Accumulatore di Planté

Pila Daniell

Pila di Grove

Pila Leclanché

Pila Bunsen

Batterie primarie di uso comune

Le pile primarie, chiamate comunemente batterie, sono quelle pile le cui reazioni chimiche interne sono irreversibili. In altre parole, non è possibile invertire la reazione completa semplicemente fornendo energia alla pila; quindi, in sostanza, quando tutti i reagenti della pila si trasformano completamente nei prodotti finali, essa si scarica definitivamente divenendo inutilizzabile. Segue la tipologia delle batterie primarie che si possono trovare in commercio:

Pila zinco-carbone

Rappresentazione schematica di una pila zinco-carbone; il catodo (+) è una barretta di grafite, il contenitore esterno di zinco funge da anodo (-)

La prima pila a secco (priva di liquidi) prodotta industrialmente e commercializzata su ampia scala fu la pila zinco-carbone, brevettata nel 1886 dal Dr Carl Gassner, che sviluppò un prototipo inventato e brevettato da Georges Leclanché nel 1866 (la cosiddetta pila Leclanché). In sostanza la precedente pila Leclanché aveva i due elettrodi immersi in una soluzione acquosa elettrolita di cloruro di zinco e cloruro di ammonio, per cui non può essere considerata una vera e propria pila a secco.

La pila zinco-carbone ha forma cilindrica ed è costituita da un anodo di zinco metallico che occupa la base inferiore e la superficie del cilindro, fungendo quindi anche da contenitore. All'interno troviamo una pasta gelatinosa di biossido di manganese e cloruro di ammonio, misti ad una polvere di carbone. Il catodo è costituito da una barretta di grafite, immersa in questa pasta e la cui sommità, ricoperta da un cappuccio metallico, sporge sulla base superiore del cilindro. Una plastica sigillante divide il cappuccio metallico dal contenitore di zinco, in modo da evitare il corto circuito tra anodo e catodo.

La semireazione di riduzione avviene sulla superficie del catodo di grafite e coinvolge il biossido di manganese. La stechiometria della reazione di riduzione non è esattamente nota ed è probabilmente costituita da più reazioni parallele. Reazioni rappresentative sono le seguenti:

2 MnO2 + 2 NH

+

4

+ 2 e− → 2 MnO(OH) + 2 NH3

2 MnO2 + 2 NH

+

4

+ 2 e− → Mn2O3 + 2 NH3 + H2O

La barra di grafite e la polvere di carbone non partecipano alla reazione e servono solo per facilitare la conduzione degli elettroni. La semireazione di ossidazione avviene sulla superficie interna del contenitore di zinco e può essere così espressa:

Zn → Zn2+ + 2 e−

Il cloruro d'ammonio, oltre a fornire gli ioni H+ per la semireazione (o semireazioni) di riduzione, ha anche il compito di complessare gli ioni zinco prodotti dalla semireazione di ossidazione, mantenendo quindi bassa la concentrazione degli ioni Zn2+ liberi, e quindi mantenendo basso il potenziale di riduzione (E) della coppia redox Zn/Zn2+, secondo l'equazione di Nernst:

Zn2+ + 4 NH

+

4

+ 4 OH− → [Zn(NH3)4]2+ + 4 H2O

Zn e MnO2 sono entrambi solidi per cui, non avendo la pila un vero e proprio ponte salino, sono fisicamente a contatto e reagiscono all'interno della pila anche se lentamente. I potenziali di riduzione all'anodo e catodo (E) sono difficili da calcolare sia perché sono instabili a causa delle variazioni delle specie ioniche coinvolte nelle due semireazioni (secondo l'equazione di Nernst E dipende dalla concentrazioni molari delle specie ioniche coinvolte nella semireazioni), sia perché sono diverse le semireazioni di riduzione al catodo. In ogni caso la differenza di potenziale (d.d.p) o forza elettromotrice (f.e.m.) di una pila zinco carbone giovane (∆E) è circa 1,5 V.

La pila zinco-carbone ha numerosi svantaggi: il contatto fisico Zn e MnO2 e l'ambiente acido della pila non impediscono la reazione di ossidoriduzione anche a riposo, rendendo relativamente elevato il processo di scarica a riposo. Le numerose reazioni parallele portano alla formazione di numerose sostanze che aumentano la resistenza interna della pila, abbassando il ∆E che dall'iniziale 1,5 V si riduce rapidamente. Anche l'ammoniaca che si libera al catodo tende a formare un velo gassoso sulla sua superficie, aumentando la resistenza interna e quindi abbassando il ∆E. In altre parole la pila ha facilità a scaricarsi. Un problema aggiuntivo è dato dall'assottigliamento della parete di zinco della pila a causa della semireazione di ossidazione. Questo porta a problemi di perdita del contenuto interno.

Tutti questi limiti hanno impedito alle pile zinco-carbone di rimanere competitive e hanno fatto sì che fossero sostituite gradualmente dalle pile alcaline. Sono comunque più economiche di queste ultime e restano ancora oggi reperibili sul mercato.

Pile alcaline

Alcune pile alcaline

Rappresentazione schematica di una batteria alcalina. Polvere di MnO2 (marrone); polvere di Zn (grigio chiaro); separatore (grigio scuro); barra di metallo e adesa superficie metallica che fungono da anodo e contenitore metallico che funge da catodo (grigio); sigillante di plastica e membrana di sovrappressione (giallo); etichetta (verde)

Furono inventate negli anni cinquanta da un ingegnere canadese, Lewis Urry, e sono l'evoluzione delle pile a secco zinco-carbone. L'ossidante e il riducente sono ancora biossido di manganese (MnO2) e zinco metallico (Zn), ma lo Zn non forma più il contenitore esterno essendo inserito in forma di polvere attorno ad una barra metallica inerte (anodo). MnO2 è anch'esso una polvere a contatto con il contenitore esterno metallico e inerte (catodo). Le due polveri di Zn e MnO2 sono immerse in una pasta gelatinosa, alcalina appunto, di idrossido di potassio (KOH) come elettrolita e sono separate da un separatore che fa passare ioni, ma non le due sostanze solide polverizzate. La presenza del KOH è fondamentale in quanto ha il vantaggio di non produrre gas durante il funzionamento (esempio NH3) e di non avere cadute di tensione (∆E), che rimane costante e pari ad 1,5 V. L'estremità della barra di metallo che funge da anodo è a contatto con un dischetto di metallo sulla base inferiore del cilindro della pila, estendendo quindi la funzione anodica a tutto il dischetto. Quest'ultimo è separato dal contenitore esterno catodico di metallo da un sigillante di plastica non conduttore che evita il corto circuito.

La semireazione di riduzione avviene sulla superficie metallica catodica (inerte) e coinvolge il biossido di manganese. La stechiometria della semireazione di riduzione non è esattamente nota ed è probabilmente costituita da più reazioni parallele. Una reazione rappresentativa è la seguente:

MnO2 + 2 H2O + 2 e− → Mn(OH)2 + 2 OH−

Il potenziale di riduzione (E) di questa semireazione equivale a quello standard (Eº) in quanto MnO2 e Mn(OH)2 sono solidi e OH− è ad una concentrazione molare alta, vicina ad 1 M (standard). Quindi E = Eº = +0,25 V. Tale potenziale E è inoltre costante in quanto la concentrazione molare di OH− rimane alta durante il funzionamento della pila e dell'ordine di grandezza di 1 M (KOH è il componente in eccesso). La semireazione di ossidazione avviene sulla superficie interna della barra metallica anodica (inerte) del contenitore di zinco e può essere così espressa:

Zn → Zn2+ + 2 e−

Il potenziale di riduzione (E) di questa semireazione non equivale a quello standard (Eº) in quanto la concentrazione molare di Zn2+ è molto più bassa di 1 M ([Zn2+] ≪ 1 M). La presenza di KOH fa infatti precipitare Zn(OH)2 (che poi si convertirà in ZnO), stabilendo una concentrazione bassa e costante di Zn2+:

KPS = [Zn2+] [OH−]2

Essendo KPS = 6,8 × 10−17 ed essendo [OH−] = 1 M, si può desumere che [Zn2+] = 6,8 × 10−17 . Applicando poi l'equazione di Nernst si ottiene che E = −1,25 V. Si verifica anche la reazione di formazione del complesso di coordinazione Zn(OH)

2−

4

, ma si può dimostrare che ciò non cambia la concentrazione molare di Zn2+ libero.

La reazione redox completa è:

Zn + MnO2 + H2O → ZnO + Mn(OH)2

Al catodo vengono prodotti ioni OH− e all'anodo consumati, l'elettroneutralità dei due comparti, in accordo con la legge di Kirchhoff delle correnti, viene garantita dal setto divisorio permeabile agli ioni.

A differenza della tradizionale pila zinco-carbone, nella pila alcalina entrambi i potenziali di riduzione (E) all'anodo e al catodo sono noti, stabili e costanti durante il funzionamento della pila, garantendo una ∆E = 1,5 V. Inoltre Zn e MnO2 non sono adesso a contatto (divisi dal separatore) e quindi non reagiscono tra di loro quando la pila è a riposo (non si scarica a riposo). Non si liberano gas e non vi sono reazioni indesiderate, impedendo cadute di potenziale (∆E stabile). Infine non c'è consumo del contenitore della pila e quindi non ci sono perdite.

La pila alcalina ha permesso quindi il superamento di tutti i limiti della pila zinco-carbone, sostituendola gradualmente sul mercato. L'unico svantaggio è il maggior costo.

Usi: torce elettriche, giocattoli, strumenti elettrici ed elettronici vari

Vantaggi: tempo di vita più lungo a riposo, nessuna caduta di tensione anche ad elevata intensità di corrente erogata, nessuna perdita

Batterie zinco-aria

Alcune batterie zinco-aria. Il protettore colorato protegge il catodo dal contatto con l'ossigeno dell'aria

La prima batteria zinco-aria fu realizzata da Charles Féry nel 1914 in versione “ingombrante”. Furono poi perfezionate e ridotte di volume negli anni '70. Oggi le più comuni batterie zinco-aria hanno la dimensione e forma di un bottone e sono utilizzate per apparecchi acustici da applicare all'orecchio dei non udenti, per misuratori di telemetria cardiaci ed altri apparecchi medici. Trovano applicazioni anche per telecamere ed altri oggetti.

La parete laterale interna e la base superiore della batteria sono occupati da una lastra metallica inerte che funge da anodo. Questa racchiude una pasta gelatinosa umida alcalina a base di KOH e contenente polvere di zinco. La parete laterale esterna e la base inferiore della batteria costituiscono un'altra lastra metallica inerte che funziona da catodo e che è separata dalla prima grazie a un sigillante di plastica non conduttore che evita il corto circuito. La lastra metallica catodica è forata a livello della base inferiore per far passare l'ossigeno dell'aria (O2) e sopra di essa è adagiata una carta da filtro e poi ancora un foglio di teflon, entrambi permeabili all'O2. Ancora sopra è presente un sottile strato di materiale, tenuto insieme da una rete e imbevuto dello stesso gel alcalino a base di KOH, in grado di catalizzare (accelerare) la decomposizione dell'O2. Tale gel alcalino è separato da quello contenente la polvere di zinco grazie ad un separatore permeabile agli ioni.

Sulla superficie interna della lastra anodica avviene la semireazione di ossidazione, identici nella stechiometria e nel potenziale E a quelli già descritti in precedenza per la batteria alcalina, ovvero:

Zn → Zn2+ + 2 e−

E = −1,25 V

La semireazione di riduzione avviene grazie al passaggio dell'O2 dell'aria attraverso i fori della lastra catodica, la carta da filtro e il teflon, fino a raggiungere la massa catalizzatrice:

O2 + 2 H2O + 4 e− → 4 OH−

E = +0,40 V

Il potenziale di riduzione (E) di questa semireazione equivale a quello standard (Eº) in quanto OH− è ad una concentrazione molare alta, vicina ad 1 M (standard). Quindi E = Eº = +0,40 V. Tale potenziale è inoltre costante in quanto la concentrazione molare di OH− e la pressione parziale di O2 rimangono alte e costanti durante il funzionamento della pila.

La reazione di ossidoriduzione completa è:

2 Zn + O2 → 2 ZnO

∆E = 1,65 V

Come nella pila alcalina entrambi i potenziali di riduzione (E) all'anodo e al catodo sono noti, stabili e costanti durante il funzionamento della pila, garantendo una ∆E = 1,65 V. La batteria è economica e ha alta densità di energia grazie all'assenza di immagazzinamento dell'ossidante. La scarica a riposo della pila è trascurabile se è mantenuto il sigillante sulla parete catodica che impedisce il passaggio di O2. In assenza del sigillante l'O2 diffonde facilmente fino a dentro la pila ossidando lo Zn. Altro svantaggio è costituito dalla potenza molto ridotta che ne limita l'uso ad apparecchi di piccola dimensione.

Usi: apparecchi acustici, misuratori telemetrici cardiaci, strumenti elettrici ed elettronici a bassa potenza

Vantaggi: dimensione piccola, alta energia specifica, ∆E stabile (∆E = +1,65 V), basso costo.

Svantaggi: bassa capacità (utilizzabili solo per piccoli strumenti), funziona male in condizioni di clima secco

Batterie ad argento

Alcune batterie ad argento

Inventata e commercializzata negli anni '50 in varie forme e dimensioni, fu utilizzata per tutta la seconda metà del secolo scorso nell'aeronautica militare, civile e spaziale. Gli alti costi di realizzazione, dovuti alla presenza dell'argento, l'hanno oggi resa poco competitiva in questi campi, ma sono ancora commercializzate e molto usate batterie da argento di piccole dimensioni, a forma di bottone, per orologi, calcolatrici, macchine fotografiche ed altri oggetti elettronici di piccole dimensioni.

La base superiore della batteria è occupata da una lastra metallica inerte che funge da anodo, mentre la base inferiore e la parete laterale sono costituiti da una simile lastra metallica inerte che funziona da catodo. Una plastica sigillante e isolante corre internamente alla parete laterale fino alla base superiore, interponendosi tra anodo e catodo ed evitando così il corto circuito. All'interno, a contatto con le basi superiore e inferiore della batteria, si trovano due paste gelatinose alcaline a base di idrossido di potassio (KOH) e contenenti una polvere di zinco (Zn) e un polvere di ossido di argento (Ag2O), rispettivamente. Queste sono separate da un separatore permeabile agli ioni che, come in tutte le pile, assicura il ristabilimento della neutralità nei due ambienti gelatinosi.

Sulla superficie interna della lastra anodica avviene la semireazione di ossidazione, identici nella stechiometria e nel potenziale E a quelli già descritti per la batteria alcalina (vedi sopra), ovvero:

Zn → Zn2+ + 2 e−

E = −1,25 V.

Sulla superficie interna della lastra catodica avviene la semireazione di riduzione:

Ag2O + H2O + 2e- → 2Ag + 2OH−

E = +0,342 V.

Il potenziale di riduzione (E) di questa semireazione equivale a quello standard (Eº) in quanto Ag2O e Ag sono composti solidi e OH− è ad una concentrazione molare alta, vicina ad 1 M (standard). Quindi E = Eº = +0,342 V. Tale potenziale è inoltre costante in quanto la concentrazione molare di OH− rimane alta e costante durante il funzionamento della pila.

La reazione redox completa è:

Zn + Ag2O -> ZnO + 2Ag

∆E = 1,6 V

Come nella pila alcalina entrambi i potenziali di riduzione (E) all'anodo e al catodo sono noti, stabili e costanti durante il funzionamento della pila, garantendo una ∆E = 1,6 V. La batteria è inoltre piccola e quindi adatta per piccoli apparecchi. La presenza dell'argento la rende tuttavia costosa.

Usi: Aeronautica militare, civile e spaziale (nel secolo scorso e con dimensioni decisamente più grandi di quelle descritte qui); orologi, calcolatrici, macchine fotografiche, telecamere ed altri oggetti elettrici ed elettronici di piccole dimensioni.

Vantaggi: dimensione piccola, ∆E stabile (∆E = +1,6 V).

Svantaggi: bassa capacità (utilizzabili solo per piccoli strumenti), costo relativamente alto

Batterie al mercurio (batterie Ruben-Mallory)

Inventata nel 1942 da Samuel Ruben fu utilizzata nel corso della seconda guerra mondiale per applicazioni militari (walkie-talkie, munizioni e metal detector). Fu commercializzata dopo la guerra in varie forme e dimensioni e trovò uso per varie applicazioni, soprattutto in piccola forma (a bottone) come per le pile ad argento descritte sopra. Fu largamente usata per orologi, calcolatrici, macchine fotografiche, ed altri piccoli oggetti. Fu anche molto utilizzata per applicazioni mediche (apparecchi acustici, pacemaker ed altri dispositivi impiantibili per via chirurgica). A partire dagli anni '90 in alcuni stati degli USA cominciarono le limitazioni per la fabbricazione di queste batterie a causa del mercurio liquido da esse prodotte, ritenuto dannoso per l'ambiente a causa dello smaltimento improprio delle batterie stesse da parte della popolazione che ne faceva uso. Oggi la produzione è vietata in tutti gli Stati Uniti, in tutta Europa ed in molti altri stati occidentali e non. Queste pile, una volta utilizzata ed esaurite, vanno assolutamente gettate negli appositi bidoni per pile esauste, poiché il materiale che le compone, ovvero il mercurio, è altamente tossico e pericoloso, sia per gli esseri umani e animali, sia per l'ambiente.

Le batterie a bottone al mercurio hanno una costituzione e una chimica molto simili a quelle delle batterie a bottone ad argento. L'unica differenza è la presenza di una polvere di ossido di mercurio (HgO) a sostituire quella di ossido di Argento (Ag2O). Sulla superficie interna della lastra catodica avviene la semireazione di riduzione:

HgO + H2O + 2e− → Hg + 2OH−

E = +0,09 V.

Il potenziale di riduzione (E) di questa semireazione equivale a quello standard (Eº) in quanto HgO e Hg sono composti indisciolti (solidi e liquidi rispettivamente) e OH− è ad una concentrazione molare alta, vicina ad 1 M (standard). Quindi E = Eº = +0,09 V. La semireazione di ossidazione e il suo potenziale sono identiche a quelle viste per la batteria alcalina e ad argento. La reazione redox completa è:

Zn + HgO → ZnO + Hg

∆E = 1,3 V

Come nella pila alcalina e ad argento entrambi i potenziali di riduzione (E) all'anodo e al catodo sono noti, stabili e costanti durante il funzionamento della pila, garantendo una ∆E = 1,3 V.

Usi: fino al loro divieto furono usate per orologi, calcolatrici, macchine fotografiche, telecamere, pacemakers, apparecchi acustici ed altri oggetti elettrici ed elettronici di piccole dimensioni

Vantaggi: dimensione piccola, ∆E stabile (∆E = +1,3 V).

Svantaggi: bassa capacità (utilizzabili solo per piccoli strumenti), alta tossicità

Batterie al litio

Una batteria al litio a bottone

Schema di una batteria al litio a bottone avente come catodo MnO2 (biossido di manganese)

Batteria al litio disassemblata. Da sinistra a destra troviamo: superficie metallica dell'anodo ricoperto internamente da uno strato di litio metallico, separatore poroso, polvere di MnO2, rete metallica conduttrice, superficie metallica del catodo (danneggiato durante l'apertura della batteria), anello di plastica sigillante

Da non confondere con le batterie ricaricabili agli ioni di litio (Li-ion).

Inventata e commercializzata nel 1970 da varie compagnie americane e giapponesi generalmente in piccola forma (ad esempio a bottone), è oggi utilizzata per orologi, macchine fotografiche, calcolatrici, telecomandi auto per chiusura centralizzata, apparati impiantabili per via chirurgica (pacemaker, defibrillatori impiantabili, impianti cocleari, sensori di glucosio, ecc.), oggetti elettronici di vario tipo.

La base inferiore della batteria è occupata da una lastra metallica inerte che funge da anodo, mentre la base superiore è costituita da una simile lastra metallica inerte che funziona da catodo. Un anello di plastica sigillante tiene unite le due lastre impendendone allo stesso tempo il contatto fisico e quindi il corto circuito. All'interno, la base inferiore è a contatto con uno o più strati di litio (Li) immersi in un solvente organico aprotico (che non rilascia ioni H+). La base superiore è invece a contatto con un composto ossidante che può variare a seconda del tipo di batteria presa in considerazione, anch'esso immerso nello stesso solvente aprotico. I due ambienti sono divisi da un separatore poroso permeabile agli ioni, ma non a composti solidi. Nell'80% delle batterie al litio esistenti in commercio l'ossidante è biossido di manganese (MnO2), e il solvente aprotico è carbonato di propilene o 1,2-dimetossietano dove si trova disciolto come sale elettrolita LiClO4.

All'anodo avviene la semireazione di ossidazione:

Li → Li+ + e−

Tale semireazione ha in soluzione acquosa il potenziale di riduzione standard più basso in assoluto (Eº = −3,04), così basso che gli ioni H+ presenti nell'acqua o in qualunque solvente organico protico (anche in ambiente alcalino) reagirebbero in maniera esplosiva con Li metallico dando luogo alla formazione di ioni Li+ e idrogeno gassoso (H2). Questo è il motivo per cui la soluzione elettrolita della pila è in solvente organico aprotico. Al catodo avviene la semireazione di riduzione:

MnO2 + Li+ + e− → LiMnO2

In questa semireazione, gli ioni litio, provenienti dalla semireazione di ossidazione attraverso il setto poroso, si associano a MnO2 senza cambiare il proprio stato ionico e numero di ossidazione, che rimane +1. Sono piuttosto gli atomi di Mn a ridursi passando da numero di ossidazione +4 a +3 (l'assenza di acqua e di solvente protico impedisce a MnO2 di ridursi secondo le semireazioni che avvengono nella pila zinco carbone ed alcalina). In soluzione acquosa, i potenziali di riduzione standard (Eº) delle due semireazioni viste sono, rispettivamente, −3,04 V e +0,25 V, dando luogo ad una differenza di potenziale (∆Eº) di 3,29 V. Tuttavia il solvente non è acquoso e i due potenziali sono ignoti e comunque diversi dai valori standard. È nota solo la differenza di potenziale tra anodo e catodo (∆E), pari a 3 V. Le reazione redox completa è quindi:

MnO2 + Li → LiMnO2

∆E = 3 V

La batteria al litio ha comportato una vera e propria rivoluzione nel campo delle batterie che si è allargata anche alle pile secondarie (ricaricabili). La semireazione del litio ha in assoluto il valore Eº più basso, garantendo un alto valore di ∆E qualunque sia la specie chimica responsabile della semireazione di riduzione. Inoltre il Li è leggero (6,9 g/mol), permettendo di liberare un grosso quantitativo di e− per unità di massa (1 mole di e− ogni 6,9 g di Li, più di qualunque altra sostanza). Questo ha permesso di generare batterie con alti valori di ∆E (3 V) ed energia specifica (0,83-1,01 kJ/g di batteria), traducendosi in batterie di piccole dimensioni e alto potenziale. Inoltre le batterie al litio hanno alta affidabilità, tempo di vita molto lungo (10-15 anni), basso valore di scarica a riposo (circa 2% all'anno), abbassamento di ∆E lento e prevedibile e sono sigillabili in quanto non liberano H2 gassoso (queste ultime due caratteristiche sono molto utili per dispositivi impiantabili per via chirurgica). Gli unici difetti sono i costi elevati, la bassa capacità e l'infiammabilità data dalla presenza di un solvente organico piuttosto che di uno acquoso.

Usi: orologi, macchine fotografiche, calcolatrici, telecomandi auto, apparati impiantabili per via chirurgica, oggetti elettrici ed elettronici di vario tipo e piccola dimensione.

Vantaggi: dimensione piccola, tempo di vita molto lungo, ∆E alto (circa 3 V), alta energia specifica, bassa autoscarica, alta affidabilità, bassa tossicità, sigillabilità, ∆E a lento decadimento (utile per pacemakers)

Svantaggi: bassa capacità, costo elevato, infiammabilità

Pila o batteria?

I termini pila e batteria possono essere sinonimi, perché indicano entrambi un componente elettrico capace di fornire energia elettrica, ma si distinguono per il fatto che le pile hanno una disposizione delle diverse celle galvaniche in verticale (una sopra l'altra), mentre le batterie hanno una disposizione delle celle in orizzontale (una di fianco all'altra);[senza fonte] inoltre il termine pila viene utilizzato anche per indicare le celle galvaniche usate singolarmente (come nel caso delle Pile stilo, quali le AA, AAA, ecc)[14], mentre il termine batteria viene utilizzato anche per indicare una fonte energetica di corrente elettrica costituita da più celle galvaniche distinte tra loro e non fisicamente unite e vincolate tra di loro, come nel caso di "pacchi batteria" o di molte "pile fai-da-te".

Pacco batteria

Un pacco batteria composta da 4 elementi in serie (Tratado elemental de física experimental y aplicada, y de meteorología..., 1862).

Un "pacco batteria" (talvolta chiamato semplicemente "batteria") è un dispositivo costituito da diverse celle elettrochimiche distinte l'una dall'altra (le quali possono essere utilizzate anche singolarmente), utilizzate per convertire l'energia chimica accumulata in energia elettrica. Queste vengono collegate in serie in modo che le tensioni dei singoli elementi si sommino.

Batterie fai-da-te

Una batteria costruita con 4 limoni.

Una batteria costruita con 2 patate.

Quasi ogni liquido o materiale umido che possieda abbastanza specie ioniche da essere elettricamente conduttivo può servire da elettrolita per una pila. Come originale dimostrazione scientifica, è possibile inserire due elettrodi fatti di metalli differenti in un limone,[15] una patata, un bicchiere contenente una bibita, ecc. e generare piccole quantità di corrente elettrica. Le pile "casalinghe" di questo tipo non sono di utilità pratica perché producono meno corrente e costano assai più per unità d'energia prodotta rispetto alle batterie commerciali, in relazione alla necessità di dovere rimpiazzare frequentemente il frutto o il vegetale adoperato, ed in quanto la corrente elettrica è prodotta non tanto dal frutto in sé, quanto dalla corrosione dei poli metallici con cui esso è a contatto, che alla lunga risulteranno rovinati da tale corrosione; ciò ne fa un processo entalpicamente in perdita, tenuto conto della maggiore quantità di energia che era stata necessaria a produrre quel metallo rispetto a quella restituita dalla sua distruzione. A livello didattico, una classica pila fai-da-te può essere costituita da un limone nel quale vengono piantate due barrette, una di rame ed una di zinco. Si ottiene così una differenza di potenziale di circa 1 V, ed una capacità di corrente appena sufficiente per far illuminare un LED a basso consumo o alimentare un orologio a cristalli liquidi. Nel 2010 è stata resa nota l'innovazione di utilizzare la patata bollita (scoperta da un team israeliano) invece di quella cruda e questo consente di aumentare di 10 volte l'energia ricavabile grazie alla corrispondente diminuzione della resistenza interna dell'elettrolita.[16] La tensione resta sempre quella del sistema rame-zinco ovvero rimpiazza le cosiddette pile a 1,5 volt. Mettendo in serie (collegando + di una con - di un'altra) o in parallelo (collegare + con + e − con −) più pile è possibile sommare rispettivamente la tensione o la corrente. Le pile a patata bollita è stato calcolato che vengono a costare e forniscono un'energia da 5 a 50 volte più economica di quelle tradizionali e sono quindi molto adatte per progetti nei paesi più poveri. Ovviamente tali patate non saranno più commestibili, vista la tossicità dovuta all'assorbimento di sali organici di rame e zinco.

Le batterie al piombo-acido possono essere facilmente prodotte in casa, ma un fastidioso ciclo di carica/scarica è necessario per "formare" le piastre. Questo è un processo che porta alla formazione di solfato di piombo sulle piastre e durante la carica questo viene convertito in diossido di piombo (piastra positiva) e piombo puro (piastra negativa). La ripetizione di questo processo porta come risultato una superficie microscopicamente ruvida, con una ben più grande superficie esposta. In questo modo aumenta la corrente che la batteria può erogare.

Capacità e tensioni differenti

In alcuni casi è possibile utilizzare celle galvaniche o batterie con caratteristiche differenti, ma con i dovuti accorgimenti, in generale con il collegamento in serie si deve avere celle galvaniche di pari capacità e tensione, ma nel caso di batterie in serie è possibile utilizzare anche elementi con la metà della capacità se hanno anche la metà della tensione, in quanto i singoli elementi delle batterie (celle galvaniche) avranno le stesse caratteristiche; nel caso di collegamenti in parallelo l'unico vincolo è la tensione, che deve essere uguale per ogni elemento collegato (celle galvaniche o batterie), mentre la capacità può essere anche estremamente differente; è possibile anche avere serie di paralleli o paralleli di serie, l'importante è rispettare i vincoli tipici per ogni singola serie, in tutti i casi i collegamenti devono essere fatti con elementi della stessa natura, quindi non mescolare tecnologie differenti in quanto hanno valori di riferimento e curve di carica e gestione differenti.

Gli inconvenienti del collegamento sono l'interruzione del singolo elemento o la loro cortocircuitazione; in caso d'interruzione i collegamenti in serie smettono di funzionare, mentre quelli in parallelo perdono solo la capacità di quell'elemento, in caso di cortocircuito il collegamento in serie perde solo la quota di tensione di quell'elemento che comunque può surriscaldarsi, mentre nel collegamento in parallelo si verifica una scarica veloce di tutti gli elementi in parallelo con forte rischio d'esplosione in quanto si verifica un forte surriscaldamento.

I collegamenti in parallelo anche senza inconvenienti risentono del potenziale problema legato allo scaricarsi più velocemente di una cella rispetto a quella vicina, che porta la corrente a circolare dalla cella carica a quella scarica, sprecando in tal modo energia. Nel caso delle batterie in serie, se un singolo elemento perde di capacità o è di capacità inferiore a parità di tensione, questo tenderà a caricarsi e scaricarsi prima degli altri, andando continuamente in sovraccaria/sovratensione e sottotensione, stressandosi maggiormente rispetto agli altri elementi e compromettendo la vita del sistema in serie.

Batterie di flusso

Magnifying glass icon mgx2.svg Lo stesso argomento in dettaglio: Batteria di flusso.

Le batterie di flusso sono una classe speciale di batterie dove quantità addizionali di elettrolita sono conservate fuori dalla cella galvanica principale e vengono fatte circolare all'interno di essa tramite pompe o sfruttando la forza di gravità. Le batterie di flusso possono avere una capacità estremamente grande e sono usate in applicazioni navali, mentre stanno guadagnando popolarità nell'ambito di applicazioni riguardanti lo stoccaggio dell'energia.

Le batterie di flusso zinco-bromo e le batterie redox al vanadio sono tipici esempi di batterie di flusso commercialmente disponibili.

Specifiche tecniche

Parametri di riferimento

Una batteria è caratterizzabile nelle sue prestazioni/caratteristiche dai seguenti parametri fisico-elettrici:

Tensione, differenza di potenziale (misurata in volt);

Corrente elettrica o intensità di corrente (misurata in ampere);

Capacità (espressa in ampereora Ah).

Dimensioni comuni

Vari tipi di batterie: da sinistra, batteria da 4,5 volt, torcia (D), mezza torcia ©, stilo (AA), mini stilo (AAA), AAAA, A23, 9 volt, e due pile a bottone.

Batterie sia monouso sia ricaricabili sono in commercio in varie dimensioni standard, in modo tale che lo stesso tipo di batteria possa essere utilizzata per svariate applicazioni, non sussistono problemi di compatibilità tra batterie dello stesso tipo. Tra i tipi maggiormente usati per dispositivi portatili includono la serie A, tra cui AA e AAA, comunemente dette "stilo" e "mini stilo"; C o "mezza torcia"; D o "torcia"; PP3 o "9 volt" comune nelle radioline; 4,5 volt, di dimensioni relativamente grandi; varie dimensioni di pile a bottone, e altri tipi specializzati.

Capacità comuni

Le informazioni riguardanti la capacità in Ah delle batterie ricaricabili sono normalmente facilmente disponibili, ma può essere molto più difficoltoso ricavare la capacità per le batterie primarie. A titolo di esempio, alcune capacità di batterie primarie Energizer sono presenti in Energizer Technical Information mentre in Electric Current from a 1.5 Volt Battery sono presenti dei valori relativi ad alcune Duracell.

La capacità delle batterie, ovvero la quantità di carica elettrica che può essere immagazzinata, è comunemente espressa in ampere-ora (Ah), dove 1 Ah equivale a 3 600 coulomb. Per ottenere l'energia in wattora è necessario moltiplicare la capacità in Ah per la tensione nominale.

Una batteria da 1 Ah può erogare una corrente di 0,1 ampere per dieci ore prima di scaricarsi. In realtà la capacità reale è molto dipendente dal tasso di scaricamento, decrescendo con l'aumentare della corrente richiesta. Per questo una batteria da 1 Ah solitamente non riesce a fornire 1 ampere per un'ora.

Di solito la capacità è intesa come il prodotto tra la corrente erogata, misurata nell'arco di 10 o 20 ore, e il tempo.

La capacità è misurata sperimentalmente sottoponendo la batteria ad un ritmo di scarica standard, solitamente con una corrente che faccia scaricare la batteria in venti ore ovvero una corrente pari alla capacità della batteria diviso venti ore.

Ci sono in commercio dei tester di capacità delle batterie primarie (non ricaricabili) e secondarie (ricaricabili).

Componenti e fattori elettrici

Le celle di cui si compone una batteria possono essere collegate in parallelo, in serie o in entrambe i modi. In entrambi i casi possono verificarsi problemi dal tipo di collegamento e danno del singolo componente, perciò solitamente costituite da un circuito elettronico atto a proteggerle da questi problemi, chiamato "sistema di gestione della batteria". In entrambi i tipi in serie e in parallelo, l'energia totale di una batteria equivale alla somma delle energie immagazzinate in tutte le singole celle. Una combinazione di celle in parallelo possiede la stessa tensione di una singola cella ma è in grado di fornire una corrente maggiore ed eguale alla somma delle singole correnti di tutte le celle. Una combinazione in serie possiede la stessa corrente di una singola cella ma il valore della sua tensione corrisponde alla somma delle tensioni di tutte le singole celle.

Un semplice modello circuitale di una batteria è una sorgente di tensione perfetta (cioè priva di resistenza interna) in serie con un resistore. La tensione erogata dalla sorgente di tensione non dipende dallo stato di carica, ma solo dalle caratteristiche chimiche della batteria. Quando una batteria "si consuma", è la sua resistenza interna ad aumentare. Quando la batteria è collegata ad un carico (il dispositivo che "usa" la pila, per esempio una lampadina, o un motore elettrico) che ha una sua resistenza, la tensione applicata agli estremi del carico dipende dal rapporto tra la resistenza di carico e quella interna della batteria: quando la batteria è completamente carica la sua resistenza interna è bassa, per cui la tensione applicata ai capi del carico è quasi uguale a quella della sorgente di tensione. Mano a mano che la batteria si consuma e la sua resistenza interna cresce, aumenta anche la caduta di tensione ai capi della resistenza interna, con il risultato di ridurre la tensione disponibile per il carico e quindi la capacità della batteria di erogare potenza al carico.

Trattamento termodinamico della pila: equazione di Nernst[modifica | modifica wikitesto]

In elettrochimica, l'equazione di Nernst esprime il potenziale d'elettrodo (E), relativamente al potenziale d'elettrodo standard (Eº), di un elettrodo o di un semielemento o di una coppia redox di una pila. In altre parole serve per calcolare il potenziale dell'elettrodo in condizioni diverse da quelle standard.

{\displaystyle E=E^{0}+{\frac {RT}{nF}}\ln \left[{\frac {\Pi \left(C_{\mbox{i,ox}}^{\nu _{ox}}\right)}{\Pi \left(C_{\mbox{i,red}}^{\nu _{red}}\right)}}\right]} E=E^{0}+{\frac {RT}{nF}}\ln \left[{\frac {\Pi \left(C_{{{\mbox{i,ox}}}}^{{\nu _{{ox}}}}\right)}{\Pi \left(C_{{{\mbox{i,red}}}}^{{\nu _{{red}}}}\right)}}\right]

dove:

R è la costante universale dei gas, uguale a 8,314472 J K−1 mol−1 o 0,082057 L atm mol−1 K−1

T è la temperatura assoluta

Ci,red è la molarità della specie i-esima in forma ridotta (a destra della freccia della semireazione di riduzione)

Ci,ox è la molarità della specie i-esima in forma ossidata (a sinistra della freccia della semireazione di riduzione)

νi è il coefficiente stechiometrico della specie i-esima nella semireazione di riduzione

n è il numero di elettroni trasferiti nella semireazione

F è la costante di Faraday, uguale a 9,6485309 × 104 C mol−1.

L'equazione di Nernst andrebbe in realtà espressa considerando le attività delle specie i-esima, ma per soluzioni non troppo concentrate, la relazione si può esprimere attraverso le concentrazioni molari.

Come si è arrivati all'equazione di Nernst? Trattando una pila nel suo insieme (cioè formata da due elettrodi o semielementi o coppe redox), possiamo scrivere, ad esempio per la pila Daniell:

Zn(s) + Cu2+(aq) → Zn2+(aq) + Cu(s)

Dal punto di vista termodinamico, visto che nella reazione compare una fase solida e una soluzione liquida, viene considerata solo quest'ultima, in quanto l'attività o concentrazione molare dei solidi puri è unitaria per definizione. Siccome per soluzioni molto diluite l'attività adimensionale degli ioni coincide numericamente con la loro concentrazione molare, sarà lecito scrivere per ogni specie elettroattiva:

μ = μº + RT ln [ione]

dove l'argomento del logaritmo rappresenta la concentrazione dello ione in moli per litro in condizioni attuali. Ovviamente tale operazione è errata matematicamente, in quanto non è possibile eseguire il logaritmo di una quantità dotata di dimensioni, tuttavia va ipotizzato che la concentrazione sia divisa per una concentrazione molare di riferimento unitaria (condizioni standard). Nel caso della reazione in questione e con questa precisazione, si scriverà quindi:

ΔG = μ(Zn2+) + μ(Cu) − μ(Zn) − μ(Cu2+)

ΔGº = μº(Zn2+) + μº(Cu) − μº(Zn) − μº(Cu2+)

ottenendo l'equazione isoterma di Van't Hoff

ΔG = ΔGº + RT ln([Zn2+]/[Cu2+])

In una reazione chimica infatti la variazione dei potenziali chimici dei prodotti e dei reagenti moltiplicati per i rispettivi coefficienti stechiometrici (1 nel caso in esame) col il segno positivo per i prodotti e negativo per i reagenti, è uguale alla variazione di energia libera di Gibbs ΔG per mole. In particolare a pressione e temperatura costante, in un sistema che compie lavoro utile (dovuto in questo caso alla forza elettromotrice della pila, che produce lavoro all'esterno tramite chiusura del circuito), l'energia libera di Gibbs per mole si identifica quantitativamente col lavoro utile cambiato di segno. Tale lavoro utile lo chiameremo con ΔVext e sapendo che il potenziale elettrico non è altro il lavoro per unità di carica, si può definire il lavoro elettrico come il potenziale elettrico moltiplicato per la carica. La carica è relativa ad una mole di sostanza, perciò indicando con n la quantità elettroni per quantità di reagente scambiato durante la reazione, e ricordando che la carica elettrica dell'elettrone è di 96 485 coulomb/mol (che costituisce 1 faraday, indicato con F), si può scrivere che:

Lutile = Lelettrico = n F ΔVext

In condizioni di equilibrio, ΔV tende a zero, quindi:

ΔVext = ΔVint = ∆E = forza elettromotrice (o tensione elettrica, potenziale) della pila

Di conseguenza:

Lutile = n F ∆E

Ricordando che a P e T costanti, la variazione di energia libera di un tale sistema è uguale al lavoro utile cambiato di segno,

ΔG = ΔGº + RT ln([Zn2+]/[Cu2+]) = − n F ∆E

∆E = − ΔGº/nF – (RT/nF) ln([Zn2+]/[Cu2+])

∆E = ∆Eº + (RT/nF) ln([Cu2+]/[Zn2+])

In forma più generale:

∆E = ∆Eº + (RT/nF) lnQ

dove Q è il quoziente di reazione (rapporto adimensionale tra le attività elevate ai rispettivi coefficienti stechiometrici). Possiamo quindi dire che la forza elettromotrice di una pila (∆E) è uguale al suo valore nelle condizioni standard (∆Eº) più il termine che dipende dalla attività in condizioni attuali delle specie elettroattive (ioni, gas) che partecipano alla reazione.

Scrivendo poi i termini indicati con "∆" per esteso (indicando cioè le differenze) otteniamo:

Ered − Eox = E

o

red

− E

o

ox

+ (RT/nF) ln([Cu2+]) − (RT/nF) ln([Zn2+])

dove Ered e Eox sono i potenziali di riduzione non standard delle coppie redox che subiscono le semireazioni di riduzione e ossidazione, rispettivamente; E

o

red

e E

o

ox

sono i corrispettivi potenziali di riduzione standard. Separando i termini relativi alle coppie redox che subiscono le semireazioni di riduzione e ossidazione si può scrivere l'equazione di Nernst nella sua forma base da cui siamo partiti:

Ered = E

o

red

+ (RT/nF) ln([Cu2+])

Eox = E

o

ox

+ (RT/nF) ln([Zn2+])

Sistema di gestione della batteria

Il sistema di gestione della batteria (battery management system o BMS) serve nel caso di alcune particolari tecnologie (litio, ecc) dove vengano utilizzate più celle galvaniche in serie, in modo da controllare le singole celle, stabilizzandole sia nella fase di carica che di scarica, per evitare malfunzionamenti o danneggiamenti della stessa batteria.

Generalmente tale sistema è integrato dentro al pacco batteria, la quale può essere così utilizzata come una batteria tradizionale ed essere collegata tranquillamente al caricabatteria o all'oggetto che la utilizzerà.

Considerazioni sulla sicurezza e ambientali: Riciclaggio e rigenerazione[modifica | modifica wikitesto]

Batteria nel suo alloggiamento con sopra riportate le manovre da evitare

Contenitore per la raccolta di pile esauste (in rosso).

Le varie batterie e pile essendo dei generatori o accumulatori di energia elettrica in caso di manomissione o uso incorretto possono provocare danni, per cui su di esse vengono impressi simboli o diciture per ricordare le manovre da evitare in assoluto.

Sin dal loro primo sviluppo risalente a oltre 200 anni fa, le batterie sono rimaste tra le fonti di produzione di energia relativamente più costose e la loro produzione richiede il consumo di molte risorse di un certo valore e spesso implicano anche l'impiego di sostanze chimiche pericolose, per questo fin dagli anni '20 si è cercato di recuperare questi elementi rigenerandoli (ridandogli carica elettrica), operazione che richiede differenti circuiti e non adatta a tutti i tipi di pile oppure si attua il riciclo delle loro componenti.[18] Per questa ragione esiste una specifica rete di riciclaggio (in italia regolamentata dal decreto legislativo 188 del 2008 che prevede sistemi collettivi e consorzi che raggruppano i produttori di pile e batterie, responsabili secondo la normativa della gestione dei rifiuti di questi prodotti) atta a recuperare dalle batterie usate parte dei materiali di maggiore tossicità e anche altri materiali di un certo valore. Le norme italiane prevedono che le batterie esauste siano considerate a tutti gli effetti dei rifiuti pericolosi e che quindi l'intero ciclo di vita dello smaltimento sia tracciato da parte di chi genera il rifiuto e da chi lo smaltisce. Eventuali irregolarità sono penalmente perseguibili.

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*

Guest_deleted32173_*